INFINIBAND NETZWERKLÖSUNGEN

Komplexe Workloads erfordern eine ultraschnelle Verarbeitung von hochauflösenden Simulationen, extrem großen Datensätzen und hochparallelen Algorithmen. Da diese Anforderungen immer weiter steigen, bietet NVIDIA InfiniBand - die weltweit einzige vollständig entlastbare In-Network-Computing-Plattform - den dramatischen Leistungssprung, der erforderlich ist, um eine unübertroffene Leistung im High-Performance-Computing (HPC), in der Künstlichen Intelligenz (KI) und in Hyperscale-Cloud-Infrastrukturen mit weniger Kosten und Komplexität zu erreichen.

INFINIBANDADAPTER

InfiniBand Host-Channel-Adapter (HCAs) bieten eine extrem niedrige Latenzzeit, einen extremen Durchsatz und innovative NVIDIA In-Network Computing Engines, um die Beschleunigung, Skalierbarkeit und funktionsreiche Technologie zu liefern, die für die modernen Workloads von heute erforderlich sind.

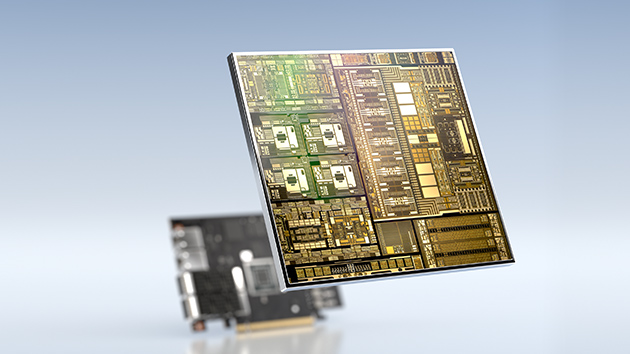

DATA PROCESSING UNITS (DPUs)

Die NVIDIA® BlueField® DPU kombiniert leistungsstarke Rechenleistung, Hochgeschwindigkeitsnetzwerke und umfassende Programmierbarkeit, um softwaredefinierte, hardwarebeschleunigte Lösungen für die anspruchsvollsten Workloads bereitzustellen.

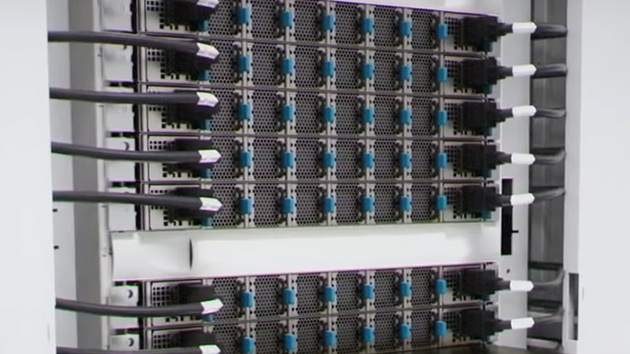

INFINIBAND SWITCHES

InfiniBand-Switch-Systeme bieten die höchste verfügbare Leistung und Portdichte. Innovative Funktionen wie NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol (SHARP)™ und erweiterte Managementfunktionen wie selbstheilende Netzwerkfunktionen, Quality of Service, erweitertes virtuelles Lane Mapping und NVIDIA In-Network Computing-Beschleunigungsengines sorgen für einen Leistungsschub bei industriellen, KI- und wissenschaftlichen Anwendungen.

ROUTER UND GATEWAYSYSTEME

InfiniBand-Systeme bieten höchste Skalierbarkeit und Subnetzisolierung durch InfiniBand-Router, InfiniBand-Long-Reach-Verbindungen (NVIDIA MetroX®-2) und InfiniBand-Ethernet-Gateway-Systeme (NVIDIA Skyway™). Letztere ermöglichen eine skalierbare und effiziente Verbindung von InfiniBand-Rechenzentren mit Ethernet-Infrastrukturen.

LINKX INFINIBAND Kabel und TRANSCEIVERS

NVIDIA LinkX® Kabel und Transceiver wurden entwickelt, um die Leistung von HPC-Netzwerken zu maximieren, die hohe Bandbreiten, niedrige Latenzen und äußerst zuverlässige Verbindungen zwischen InfiniBand-Elementen erfordern.

INFINIBAND ENHANCED CAPABILITIES

NETZINTERNE DATENVERARBEITUNG

Das NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol (SHARP)™ verlagert kollektive Kommunikationsvorgänge vom Rechenzentrum zum Switch-Netzwerk. Dieser innovative Ansatz verringert die Datenmenge, die das Netzwerk durchläuft, reduziert die Zeit für MPI-Operationen (Message Passing Interface) drastisch und erhöht die Effizienz des Rechenzentrums.

SELBSTHEILUNGSNETZWERK

Bei HPC und KI sind Cluster auf eine schnelle und zuverlässige Verbindung angewiesen. NVIDIA InfiniBand mit selbstheilenden Netzwerkfunktionen überwindet Verbindungsausfälle und ermöglicht eine 5.000-mal schnellere Netzwerkwiederherstellung als jede andere softwarebasierte Lösung. Die selbstheilenden Netzwerkfunktionen nutzen die in der neuesten Generation von InfiniBand Switches integrierte Intelligenz.

QUALITÄT DER DIENSTLEISTUNG

InfiniBand ist die einzige Hochleistungs-Verbindungslösung mit bewährten Quality-of-Service-Funktionen, einschließlich fortschrittlicher Staukontrolle und adaptivem Routing, was zu einer unübertroffenen Netzwerkeffizienz führt.

NETZWERKTOPOLOGIEN

InfiniBand verfügt über eine vollständig zentralisierte Verwaltung und kann jede Topologie unterstützen. Zu den beliebtesten Topologien gehören Fat Tree, Hypercubes, mehrdimensionaler Torus und Dragonfly+. Optimierte Routing-Algorithmen sorgen für optimierte Leistung beim Entwurf einer Topologie für bestimmte Anwendungskommunikationsmuster.

SOFTWARE FOR OPTIMAL PERFORMANCE

MLNX_OFED

OFED von der OpenFabrics Alliance (www.openfabrics.org) wurde durch gemeinsame Entwicklung und Tests von führenden Anbietern von Hochleistungs-Input/Output (IO) gehärtet. NVIDIA MLNX_OFED ist eine von NVIDIA getestete und verpackte Version von OFED.

NVIDIA HPC-X® ist eine umfassende MPI- und SHMEM/PGAS-Software-Suite. HPC-X nutzt InfiniBand In-Network Computing und Beschleunigungsengines zur Optimierung von Forschungs- und Industrieanwendungen.

UFM

Die NVIDIA UFM® Plattform ermöglicht Rechenzentrumsadministratoren die effiziente Bereitstellung, Überwachung, Verwaltung und proaktive Fehlerbehebung ihrer InfiniBand Netzwerkinfrastruktur.

MAGNUM IO

NVIDIA Magnum IO™ nutzt Netzwerk-IO, In-Network Computing, Speicher und IO-Management, um die Datenbewegung, den Zugriff und die Verwaltung für Multi-GPU- und Multi-Node-Systeme zu vereinfachen und zu beschleunigen. Magnum IO ermöglicht NVIDIA-GPU- und NVIDIA-Netzwerkhardware-Topologien, um einen optimalen Durchsatz und niedrige Latenzzeiten zu erreichen.