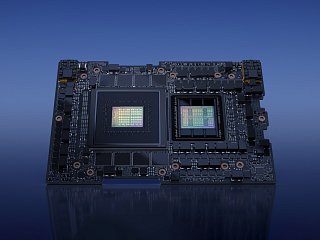

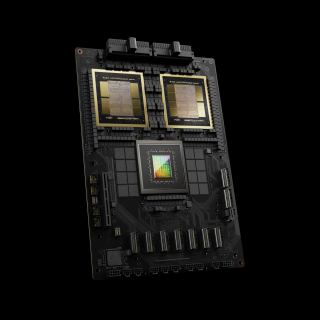

Die NVIDIA Rubin-Plattform Der neue Standard für agentische KI und logisches Schlussfolgern

Die KI-Evolution schaltet einen Gang höher: Mit der neuen NVIDIA Rubin-Plattform präsentiert NVIDIA den Nachfolger der Blackwell-Architektur. Ausgestattet mit wegweisendem... Zum Blogartikel