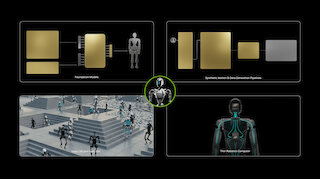

NVIDIA Jetson Developer Kits

Accelerate Edge AI and Robotics Innovation

Die NVIDIA® Jetson™ Plattform bietet maximale Leistung für Edge AI, Robotik und Embedded-Anwendungen. Mit der Jetson Software, dem JetPack SDK und den Jetson Modulen können Entwickler KI-Lösungen schnell entwickeln und umsetzen. Die NVIDIA® Jetson™ Developer Kits – darunter das Jetson AGX Thor Developer Kit, das NVIDIA Jetson Orin Nano™ Super Developer Kit und das Jetson AGX Orin Developer Kit – kombinieren ein Jetson Modul mit einem Referenzträgerboard und standardisierten Schnittstellen und ermöglichen so flexible Entwicklung, Prototyping und Testing für die nächste Generation von KI-Produkten.