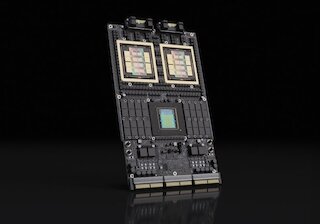

Die NVIDIA Rubin-Plattform

Der neue Standard für agentische KI und logisches SchlussfolgernDie KI-Evolution schaltet einen Gang höher: Mit der neuen NVIDIA Rubin-Plattform präsentiert NVIDIA den Nachfolger der Blackwell-Architektur. Ausgestattet mit wegweisendem HBM4-Speicher, der neuen Vera-CPU und einer massiven Steigerung der Rechenleistung pro Watt, legt Rubin das Fundament für die nächste Generation autonomer KI-Agenten. Erfahren Sie bei sysGen, wie diese sechs neuen Chips das Rechenzentrum in einen einzigen, gigantischen KI-Supercomputer verwandeln.