900-21010-0020-000

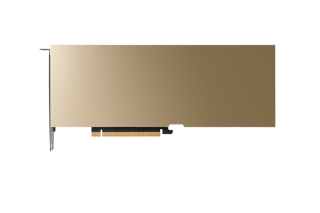

Memory Bandwidth: 3.9 TB/s

In der Welt der Künstlichen Intelligenz gibt es zwei entscheidende Phasen: das Training und das Inferencing. Während beim Training neuronale Netze aus gewaltigen Datenmengen „lernen“, ist das Inferencing der Moment der Wahrheit. Hier wendet das Modell sein gelerntes Wissen auf neue, reale Daten an, um Vorhersagen zu treffen, Bilder zu generieren oder komplexe Fragen in Millisekunden zu beantworten.

In Zeiten von Generativer KI und Large Language Models (LLMs) ist die Effizienz des Inferencing zum entscheidenden Wettbewerbsvorteil geworden. Es geht nicht mehr nur darum, ob eine KI funktioniert, sondern wie schnell, kosteneffizient und skalierbar sie im Live-Betrieb agiert.

Einsatzgebiete: Wo AI Inferencing heute den Unterschied macht

Intelligente Kundensupport-Systeme, die dank RAG-Technologie (Retrieval Augmented Generation) auf Unternehmensdaten zugreifen und in Echtzeit präzise Antworten liefern.

In der Fertigung müssen Roboter visuelle Daten sofort verarbeiten, um auf Hindernisse zu reagieren. Hier ist lokales Inferencing ohne Cloud-Umweg (Edge Computing) essenziell.

KI-Modelle analysieren CT-Bilder während der Untersuchung, um Ärzte sofort auf Anomalien hinzuweisen.

Moderne Suchmaschinen verstehen nicht nur Keywords, sondern die Absicht dahinter – ermöglicht durch blitzschnelle Vektorsuchen im Inferenz-Prozess.

Die Anforderungen an die Hardware haben sich massiv gewandelt. Wo früher einfache Klassifizierungen ausreichten, verlangen heutige Anwendungen nach extrem niedrigen Latenzen für Echtzeit-Interaktionen.

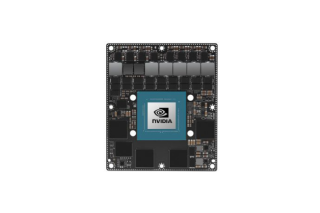

NVIDIA verfolgt einen Full-Stack-Architekturansatz, der sicherstellt, dass KI-gestützte Anwendungen mit optimaler Kosteneffizienz betrieben werden können. Das Resultat sind schnellere Ergebnisse bei reduzierten Betriebskosten. NVIDIA AI Enterprise, eine unternehmensgerechte Inferenzplattform, umfasst erstklassige Software, zuverlässiges Management, Sicherheit und API-Stabilität, um Leistungsfähigkeit und Hochverfügbarkeit zu gewährleisten.

Ein erfolgreiches KI-Projekt endet nicht mit dem Training. Um den ROI Ihrer KI-Investitionen zu maximieren, benötigen Sie eine Infrastruktur, die mit Ihren Anforderungen wächst. Von Single-GPU-Workstations für die Entwicklung bis hin zu Multi-GPU-Server-Clustern bietet sysGen maßgeschneiderte Lösungen für jedes Szenario.

Beim Training wird ein Modell mit Milliarden von Datenpunkten „gefüttert“, um Muster zu erkennen. Dies ist extrem rechenintensiv und dauert Tage bis Wochen. Inferencing ist die Anwendung des fertigen Modells. Das Modell erhält eine neue Eingabe (z.B. eine Frage) und liefert sofort ein Ergebnis. Inferencing muss schnell und effizient sein, da es oft in Echtzeit stattfindet.

Zwar kann Inferencing theoretisch auf CPUs laufen, doch für moderne Anwendungen (wie LLMs oder Bilderkennung) sind CPUs oft zu langsam. GPUs wie die NVIDIA L4 oder L40S sind darauf spezialisiert, Tausende von Berechnungen gleichzeitig durchzuführen. Das reduziert die Latenz (Reaktionszeit) und senkt die Kosten pro Abfrage massiv.

Latenz ist die Zeitspanne zwischen der Eingabe (z.B. „Schreibe ein Gedicht“) und dem Beginn der Ausgabe. Für Chatbots oder autonomes Fahren ist eine niedrige Latenz entscheidend, damit die Interaktion natürlich wirkt bzw. die Sicherheit gewährleistet ist.

Beim Edge Inferencing findet die Datenverarbeitung direkt vor Ort auf dem Gerät statt (z.B. in einer Kamera, einem Roboter oder einem Fahrzeug) und nicht in einem entfernten Rechenzentrum. Dies spart Bandbreite, schützt die Privatsphäre und eliminiert Verzögerungen durch die Internetübertragung.

Die Optimierung erfolgt auf zwei Ebenen:

RAG ist eine Methode, bei der das KI-Modell während des Inferenz-Schritts externe, aktuelle Informationen (z.B. Ihre Firmendatenbank) abfragt. Dadurch gibt die KI keine veralteten oder erfundenen Antworten, sondern greift auf Ihre spezifischen Fakten zu.