Eine Einheit. Maximale Skalierung.

Ein Rack als Supercomputer.

Mit der NVL72 Plattform bringt NVIDIA eine komplette Rack-Scale-Lösung für Training, Inferenz und AI-Reasoning. Die Systeme kombinieren modernste Grace CPUs mit Blackwell GPUs und liefern höchste Rechenleistung bei maximaler Effizienz. Die NVL72 vereint 72 GPUs und 36 Grace CPUs zu einer gemeinsamen Rechendomäne. Dank NVLink und Flüssigkühlung arbeitet das gesamte Rack wie eine einzige, hochperformante GPU. Damit lassen sich selbst Modelle mit Billionen Parametern trainieren und in Echtzeit bereitstellen.

Passend für jeden KI-Workload.

Vom LLM-Training bis zur AI-Factory.

GB200 NVL72: Für Training und Inferenz großer Sprachmodelle, optimiert auf etablierte Workloads mit maximaler Energieeffizienz.

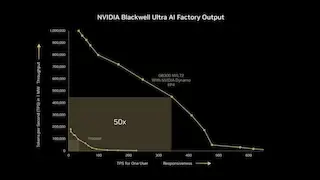

GB300 NVL72: Für AI-Factories und Reasoning, mit 40 TB Fast Memory und höherem Durchsatz pro Megawatt. Ideal für Unternehmen mit höchstem Anspruch an Skalierung und Geschwindigkeit.

Welche NVL72 passt zu Ihrem Projekt?

Vergleich der beiden Plattformen auf einen Blick.

Merkmal | GB300 NVL721 | GB200 NVL72 |

|---|---|---|

Konfiguration | 36 Grace-CPU: 72 Blackwell Ultra GPUs | 36 Grace-CPU: 72 Blackwell GPUs |

FP4 Tensor-Recheneinheit | 1.400 | 1.100² PFLOPS | 1.440 PFLOPS |

FP8/FP6 Tensor-Recheneinheit | 720 PFLOPS | 720 PFLOPS |

| INT8 Tensor-Recheneinheit | 23 POPS | 720 POPS |

FP16/BF16 Tensor-Recheneinheit | 360 PFLOPS | 360 PFLOPS |

| FP32 Tensor-Recheneinheit | 6 PFLOPS | 5.760 TFLOPS |

| FP64 Tensor-Recheneinheit | 100 TFLOPS | 2.880 TFLOPS |

Grafikprozessorspeicher | Bandbreite | Bis zu 21 TB | Bis zu 576 TB/s | Bis zu 13,5 TB HBM3e | 576 TB/s |

NVLink-Bandbreite | 130 TB/s | 130 TB/s |

Anzahl der CPU-Recheneinheiten | 2.592 Arm® Neoverse V2-Recheneinheiten | 2.592 Arm® Neoverse V2-Recheneinheiten |

CPU-Speicher | Bandbreite | Bis zu 18 TB SOCAMM mit LPDDR5X | Bis zu 14,3 TB/s | Bis zu 17 TB LPDDR5X | Bis zu 18,4 TB/s |

1. Vorläufige technische Daten. Änderungen vorbehalten. Alle technischen Daten für Tensor-Recheneinheiten sind, sofern nicht anders angegeben, mit Sparsity.

2. Ohne Sparsity.

3. Mit geringer Datendichte.

NVIDIA SuperPOD.NVL72 als Baustein für KI-Supercomputer.

Vom Rack zum Cluster:

NVIDIA SuperPOD.

NVL72 als Baustein für KI-Supercomputer.

Mehrere NVL72-Racks lassen sich über NVLink zu einem NVIDIA SuperPOD verbinden – einer vollständigen KI-Infrastruktur auf Rechenzentrums-Niveau. So entstehen skalierbare Systeme, die ExaFLOP-Leistung für Forschung und Industrie bereitstellen.

Technologische Durchbrüche mit NVIDIA Blackwell

AI Reasoning & Inferenz

Test-Time Scaling und AI Reasoning steigern den Rechenbedarf, um Qualität und Durchsatz sicherzustellen. Die Tensor Cores der NVIDIA Blackwell GPUs – in der GB300 NVL72 mit Blackwell Ultra – bieten bis zu doppelte Attention-Layer-Beschleunigung und bis zu 1,5× mehr AI-FLOPS gegenüber der vorherigen Generation.

Bis zu 288 GB HBM3e

Ein größerer Speicher ermöglicht größere Batchgrößen und maximale Durchsatzleistung. Die Blackwell GPUs in GB200 und GB300 NVL72 nutzen HBM3e – in der Ultra-Variante mit bis zu 288 GB pro GPU für besonders lange Kontextlängen und höchste Effizienz.

NVIDIA Blackwell Architektur

Die NVIDIA Blackwell Architektur setzt neue Maßstäbe in beschleunigtem Computing. Sie ermöglicht eine neue Ära von Performance, Effizienz und Skalierung – das Fundament beider NVL72 Plattformen.

NVIDIA ConnectX-8 SuperNIC

Für die GB300 NVL72 steht mit der NVIDIA ConnectX-8 SuperNIC ein I/O-Modul mit 800 Gb/s pro GPU zur Verfügung. Zusammen mit NVIDIA Quantum-X800 InfiniBand oder Spectrum-X Ethernet erreicht die NVL72 Bestwerte in Remote Direct Memory Access (RDMA) und Workload-Effizienz.

NVIDIA Grace CPU

Die NVIDIA Grace CPU ist in beiden NVL72 Plattformen das Bindeglied zwischen GPUs und Speicher. Sie kombiniert herausragende Leistung und hohe Speicherbandbreite mit doppelter Energieeffizienz gegenüber klassischen Serverprozessoren.

Fünfte Generation NVIDIA NVLink

Nahtlose GPU-zu-GPU-Kommunikation ist entscheidend für beschleunigtes Computing. Mit NVLink Gen 5 erreicht die NVL72 bis zu 1,8 TB/s Bandbreite pro GPU und verbindet alle Komponenten zu einer gemeinsamen Rechendomäne.

Jetzt Kontakt aufnehmen!

Setzen Sie auf die beste KI-Infrastruktur am Markt

Mit dem NVIDIA GB200 NVL72 & GB300 NVL72 holen Sie sich die Technologie ins Haus, die weltweit führende Unternehmen und Forschungseinrichtungen bereits erfolgreich nutzen. Lassen Sie uns gemeinsam Ihre KI-Vision verwirklichen und Ihr Unternehmen für die Zukunft rüsten.

Kontaktieren Sie sysGen noch heute und erfahren Sie, wie NVIDIA GB200 NVL72 & GB300 NVL72 Ihre KI-Strategie revolutionieren kann. Gemeinsam bringen wir Ihre KI-Projekte auf die Überholspur!

Häufige Fragen zur NVL72.

- Für wen eignet sich GB200 NVL72 besonders?

Für Organisationen, die LLMs effizient trainieren und bereitstellen wollen, mit stabiler Performance und hoher Energieeffizienz.

- Wann lohnt sich GB300 NVL72?

Bei AI-Factories und Reasoning-Szenarien mit maximalem Durchsatzbedarf.

- Kann man das NVL72 über ein einzelnes Rack hinaus ausbauen?

Zum Beispiel in Verbindung mehrerer Racks zu einem NVIDIA SuperPOD.

- Ist GB200 künftig obsolet?

Nein, GB200 bleibt eine leistungsstarke Lösung für viele Workloads. GB300 erweitert das Portfolio um höhere Kapazität und Geschwindigkeit.