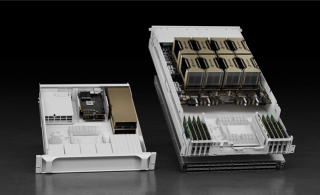

NVIDIA DGX H200 1128GB The Universal System for AI Infrastructure

8x 3.84TB NVMe U.2

2x dual-port NVIDIA ConnectX-7 VPI

1x 400Gb/s InfiniBand/Ethernet

1x 200Gb/s InifniBand/Ethernet

Unternehmen, die KI der nächsten Generation einsetzten, steigern ihren Umsatz mit 2,6-mal höherer Wahrscheinlichkeit um mindestens 10 %. Die NVIDIA DGX™ Plattform ist der bewährte Standard für Enterprise KI und unterstützt Organisationen dabei, von fortschrittlichen Sprachmodellen und generativer KI zu profitieren, Innovation voranzutreiben und Wettbewerbsvorteile zu sichern.

Die DGX Plattform integriert NVIDIA Base Command™ und NVIDIA AI Enterprise - eine umfassende Software-Suite zur Optimierung der KI-Entwicklung.

Funktionen der Software:

Diese Funktionen ermöglichen Unternehmen eine reibungslose Skalierung und beschleunigen die Markteinführung von KI-Anwendungen.

NVIDIA DGX™-Systeme sind speziell für die Anforderungen der künstlichen Intelligenz entwickelt. Sie setzen den Standard für Unternehmen, die KI-gestützte Erkenntnisse nutzen möchten, um ihre Geschäftsziele zu erreichen. Egal ob es um Kundenerfahrungen, Patientenergebnisse oder Prozessoptimierungen geht - DGX-Systeme bieten die nötige Leistung und Skalierbarkeit.

Von der Beschleunigung des Machine Learning Trainings über fortgeschrittene Datenanalysen bis hin zur Ermöglichung neuer Forschungsdurchbrüche in der Wissenschaft - NVIDIA DGX Systeme sind die Grundlage für innovative KI-Projekte weltweit.

Die NVIDIA DGX Plattform vereint die besten Technologien, Software und Infrastruktur von NVIDIA zu einer modernen, einheitlichen KI-Lösung. Sie wurde speziell entwickelt, um Unternehmen leistungsstarke KI-Entwicklung und -Training zu ermöglichen. Von Hardware bis hin zu Software ist jedes Element der DGX Plattform durch NVIDIA-Expertise geprägt, sodass Unternehmen schneller von ihren KI-Investitionen profitieren.

Die Highlights der NVIDIA DGX Plattform:

NVIDIA DGX B300 | NVIDIA DGX B200 | NVIDIA DGX H200 | NVIDIA DGX H100 (EOL) | |

|---|---|---|---|---|

| GPU | 8x NVIDIA Blackwell Ultra Tensor Core GPUs | 8x NVIDIA Blackwell Tensor Core GPUs | 8x NVIDIA Hopper Tensor Core GPUs | 8x NVIDIA Hopper Tensor Core GPUs |

| GPU Memory | 2,300GB total (8x 288GB) HBM3e | 1,440GB total (8x 180GB) HBM3e | 1,128GB total (8x 141GB) HBM3e | 640GB total (8x 80GB) HBM3 |

| Performance | 72 petaFLOPS training and 144 petaFLOPS inference | 72 petaFLOPS training and 144 petaFLOPS inference | 32 petaFLOPS FP8 | 32 petaFLOPS FP8 |

| NVIDIA® NVSwitch™ | 2x | 2x | 4x | 4x |

| System Power Usage | ~14.3kW max | ~14.3kW max | ~10.2kW max | ~10.2kW max |

| CPU | 2 Intel® Xeon® Platinum 6776P Processors | 2 Intel® Xeon® Platinum 8570 Processors Processors 112 Cores total, 2.10 GHz (Base), 4.00 GHz (Max Boost) | 2 Intel® Xeon® Platinum 8480C Processors Processors 112 Cores total, 2.00 GHz (Base), 3.80 GHz (Max Boost) | 2 Intel® Xeon® Platinum 8480C Processors Processors 112 Cores total, 2.00 GHz (Base), 3.80 GHz (Max Boost) |

| System Memory | - | Up to 4TB | Up to 2TB | Up to 2TB |

| Networking | 8x OSFP ports serving 8x single-port NVIDIA ConnectX-8 VPI 2x dual-port QSFP112 NVIDIA BlueField-3 DPU | 4x OSFP ports serving 8x single-port NVIDIA ConnectX-7 VPI 2x dual-port QSFP112 NVIDIA BlueField-3 DPU | 4x OSFP ports serving 8x single-port NVIDIA ConnectX-7 VPI 2x dual-port QSFP112 NVIDIA ConnectX-7 VPI | 4x OSFP ports serving 8x single-port NVIDIA ConnectX-7 VPI 2x dual-port QSFP112 NVIDIA ConnectX-7 VPI |

| Management Network | 1Gb/s onboard NIC with RJ45 | 10Gb/s onboard NIC with RJ45 | 10Gb/s onboard NIC with RJ45 100Gb/s dual-port ethernet NIC Host baseboard management controller (BMC) with RJ45 | 10Gb/s onboard NIC with RJ45 100Gb/s dual-port ethernet NIC Host baseboard management controller (BMC) with RJ45 |

| Storage | OS:2x 1.9TB NVMe M.2 Internal storage: 8x 3.84TB NVMe U.2 | OS:2x 1.9TB NVMe M.2 Internal storage: 8x 3.84TB NVMe U.2 | OS:2x 1.9TB NVMe M.2 Internal storage: 8x 3.84TB NVMe U.2 | OS:2x 1.9TB NVMe M.2 Internal storage: 8x 3.84TB NVMe U.2 |

| Software | NVIDIA AI Enterprise - Optimized AI Software NVIDIA Base Command - Orchestration, Scheduling, and Cluster Management DGX OS / Ubuntu - Operating System | NVIDIA AI Enterprise - Optimized AI Software NVIDIA Base Command - Orchestration, Scheduling, and Cluster Management DGX OS / Ubuntu - Operating System | NVIDIA AI Enterprise - Optimized AI Software NVIDIA Base Command - Orchestration, Scheduling, and Cluster Management DGX OS / Ubuntu - Operating System | NVIDIA AI Enterprise - Optimized AI Software NVIDIA Base Command - Orchestration, Scheduling, and Cluster Management DGX OS / Ubuntu - Operating System |

| Höheneinheiten | 10U | 10U | 8U | 8U |

| System Dimensions | HxWxL (444mm x 482mm x 897mm) | HxWxL (356mm x 482mm x 897mm) | HxWxL (356mm x 482mm x 897mm) | |

| Support | Includes 3 years NVIDIA Business Standard Support | Includes 3 years NVIDIA Business Standard Support | Includes 3 years NVIDIA Business Standard Support | Includes 3 years NVIDIA Business Standard Support |

Branchenführende Infrastruktur für den gesamten Zyklus - der schnellste Weg zu KI-Innovation im großen Maßstab.

Massive Datensätze, riesige Modelle beim Deep Learning und komplexe Simulationen erfordern mehrere Grafikprozessoren mit extrem schnellen Verbindungen und einem vollständig beschleunigten Softwarestack.