Organisations that deploy next-generation AI are 2.6 times more likely to increase revenue by at least 10%. The NVIDIA DGX™ platform is the proven standard for enterprise AI, helping organisations benefit from advanced language models and generative AI to drive innovation and secure competitive advantage.

Complete AI solution

NVIDIA DGX™ software stack

The DGX platform integrates NVIDIA Base Command™ and NVIDIA AI Enterprise - a comprehensive software suite for optimising AI development.

Features of the software:

- Cluster Management: Facilitates provisioning, monitoring and management.

- MLOps & Workflow Optimisation: Supports Kubernetes and SLURM for seamless orchestration.

- Accelerated Infrastructure: Optimised libraries for network, storage and data operations.

These features enable organisations to scale smoothly and accelerate time to market for AI applications.

NVIDIA DGX systems

The basis for innovation

- DGX B200: A unified platform for training, fine-tuning and inference. The NVIDIA Blackwell architecture offers 3x more AI training and 15x more inference performance than its predecessors.

- DGX H200: Leads organisations to new dimensions of innovation with Tensor Core GPU technology.

- DGX BasePOD™: Scalable solution for industry-specific use cases, from healthcare to finance to manufacturing

- DGX SuperPOD™: Industry-leading AI infrastructure for maximum performance and scalability.

Why NVIDIA DGX?

NVIDIA DGX™ systems are specifically designed to meet the demands of artificial intelligence. They set the standard for organisations that want to use AI-powered insights to achieve their business goals. Whether it's customer experience, patient outcomes or process optimisation, DGX systems deliver the performance and scalability you need.

NVIDIA DGX in use

From accelerating machine learning training and advanced data analytics to enabling new research breakthroughs in science, NVIDIA DGX systems are the foundation for innovative AI projects worldwide.

NVIDIA DGX platform

The proven solution for companiesThe NVIDIA DGX platform combines the best of NVIDIA's technologies, software and infrastructure into a modern, unified AI solution. It is specifically designed to enable organisations to deliver high-performance AI development and training. From hardware to software, every element of the DGX platform is characterised by NVIDIA expertise, enabling companies to benefit faster from their AI investments.

Highlights of the NVIDIA DGX platform:

- High performance: leading AI systems optimised for the toughest challenges.

- Scalability: Flexible deployment from on-premises to cloud.

- Support: Direct access to NVIDIA DGXperts for strategic advice.

- Energy efficiency: Maximum performance with minimum energy consumption.

NVIDIA DGX systems in comparison

NVIDIA DGX B300 | NVIDIA DGX B200 | NVIDIA DGX H200 | NVIDIA DGX H100 (EOL) | |

|---|---|---|---|---|

| GPU | 8x NVIDIA Blackwell Ultra Tensor Core GPUs | 8x NVIDIA Blackwell Tensor Core GPUs | 8x NVIDIA Hopper Tensor Core GPUs | 8x NVIDIA Hopper Tensor Core GPUs |

| GPU Memory | 2,300GB total (8x 288GB) HBM3e | 1,440GB total (8x 180GB) HBM3e | 1,128GB total (8x 141GB) HBM3e | 640GB total (8x 80GB) HBM3 |

| Performance | 72 petaFLOPS training and 144 petaFLOPS inference | 72 petaFLOPS training and 144 petaFLOPS inference | 32 petaFLOPS FP8 | 32 petaFLOPS FP8 |

| NVIDIA® NVSwitch™ | 2x | 2x | 4x | 4x |

| System Power Usage | ~14.3kW max | ~14.3kW max | ~10.2kW max | ~10.2kW max |

| CPU | 2 Intel® Xeon® Platinum 6776P Processors | 2 Intel® Xeon® Platinum 8570 Processors Processors 112 cores total, 2.10 GHz (Base), 4.00 GHz (Max Boost) | 2 Intel® Xeon® Platinum 8480C Processors Processors 112 Cores total, 2.00 GHz (Base), 3.80 GHz (Max Boost) | 2 Intel® Xeon® Platinum 8480C Processors Processors 112 cores total, 2.00 GHz (Base), 3.80 GHz (Max Boost) |

| System Memory | - | Up to 4TB | Up to 2TB | Up to 2TB |

| Networking | 8x OSFP ports serving 8x single-port NVIDIA ConnectX-8 VPI 2x dual-port QSFP112 NVIDIA BlueField-3 DPU | 4x OSFP ports serving 8x single-port NVIDIA ConnectX-7 VPI 2x dual-port QSFP112 NVIDIA BlueField-3 DPU | 4x OSFP ports serving 8x single-port NVIDIA ConnectX-7 VPI 2x dual-port QSFP112 NVIDIA ConnectX-7 VPI | 4x OSFP ports serving 8x single-port NVIDIA ConnectX-7 VPI 2x dual-port QSFP112 NVIDIA ConnectX-7 VPI |

| Management Network | 1Gb/s onboard NIC with RJ45 | 10Gb/s onboard NIC with RJ45 | 10Gb/s onboard NIC with RJ45 100Gb/s dual-port ethernet NIC Host baseboard management controller (BMC) with RJ45 | 10Gb/s onboard NIC with RJ45 100Gb/s dual-port ethernet NIC Host baseboard management controller (BMC) with RJ45 |

| Storage | OS:2x 1.9TB NVMe M.2 Internal storage: 8x 3.84TB NVMe U.2 | OS:2x 1.9TB NVMe M.2 Internal storage: 8x 3.84TB NVMe U.2 | OS:2x 1.9TB NVMe M.2 Internal storage: 8x 3.84TB NVMe U.2 | OS:2x 1.9TB NVMe M.2 Internal storage: 8x 3.84TB NVMe U.2 |

| Software | NVIDIA AI Enterprise - Optimised AI Software NVIDIA Base Command - Orchestration, Scheduling, and Cluster Management DGX OS / Ubuntu - Operating System | NVIDIA AI Enterprise - Optimised AI Software NVIDIA Base Command - Orchestration, Scheduling, and Cluster Management DGX OS / Ubuntu - Operating System | NVIDIA AI Enterprise - Optimised AI Software NVIDIA Base Command - Orchestration, Scheduling, and Cluster Management DGX OS / Ubuntu - Operating System | NVIDIA AI Enterprise - Optimised AI Software NVIDIA Base Command - Orchestration, Scheduling, and Cluster Management DGX OS / Ubuntu - Operating System |

| Height units | 10U | 10U | 8U | 8U |

| System dimensions | HxWxL (444mm x 482mm x 897mm) | HxWxL (356mm x 482mm x 897mm) | HxWxL (356mm x 482mm x 897mm) | |

| Support | Includes 3 years NVIDIA Business Standard Support | Includes 3 years NVIDIA Business Standard Support | Includes 3 years NVIDIA Business Standard Support | Includes 3 years NVIDIA Business Standard Support |

Suitable AI systems

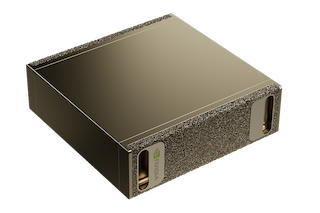

NVIDIA DGX SuperPOD

Industry-leading full-cycle infrastructure - the fastest path to AI innovation at scale.

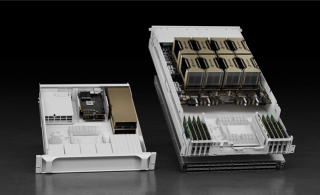

HGX AI supercomputer

Massive data sets, huge deep learning models and complex simulations require multiple graphics processors with extremely fast connections and a fully accelerated software stack.

Questions about NVIDIA DGX?

Relevant solution on the topic of AI

Engineering Simulation, Scientific Research, Genomic Sequencing, Drug Discovery

To shorten the time to discovery for scientists, researchers and engineers, more and more HPC workloads are being augmented with machine learning algorithms and GPU-accelerated parallel computing. Many of the world's fastest supercomputing clusters now utilise GPUs and the power of AI.

HPC workloads typically require data-intensive simulations and analyses with massive data sets and precision requirements. GPUs like NVIDIA's H100/H200 offer unprecedented performance with double the precision, delivering 60 teraflops per GPU.

Our Supermicro's highly flexible HPC platforms enable high GPU and CPU counts in various dense form factors with rack-scale integration and liquid cooling.