DIE HERAUSFORDERUNG DER SKALIERUNG VON ENTERPRISE AI

Jedes Unternehmen muss sich mithilfe von künstlicher Intelligenz (KI) transformieren, nicht nur um zu überleben, sondern um in schwierigen Zeiten zu gedeihen. Das Unternehmen benötigt jedoch eine Plattform für die KI-Infrastruktur, die die traditionellen Ansätze verbessert, die in der Vergangenheit langsame Rechenarchitekturen beinhalteten, die durch Analyse-, Trainings- und Inferenz-Workloads getrennt waren. Der alte Ansatz führte zu Komplexität, trieb die Kosten in die Höhe, schränkte die Skalierbarkeit ein und war nicht bereit für moderne KI. Unternehmen, Entwickler, Datenwissenschaftler und Forscher brauchen eine neue Plattform, die alle KI-Workloads vereinheitlicht, die Infrastruktur vereinfacht und den ROI beschleunigt.

Product Name XYZ - Mostly Longer than short

Product Name XYZ - Mostly Longer than shortEditable editable, click me for edit, editable, click me for edit, editable, click me for edit ...

This could be a description of a product, maybe you want to have that but it will be shortend to a certain amount of charachters ...

9.999,99 €*

DAS UNIVERSELLE SYSTEM FÜR ALLE KI-WORKLOADS

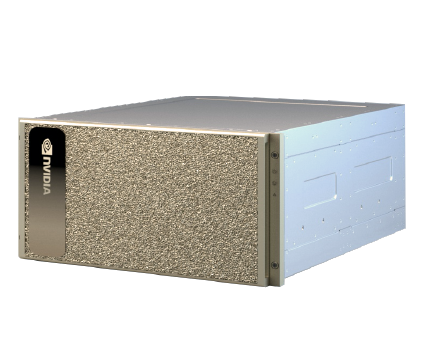

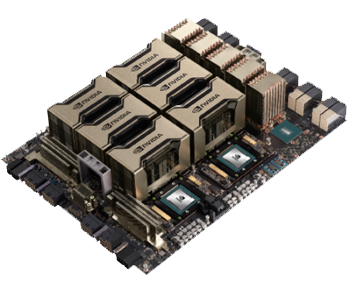

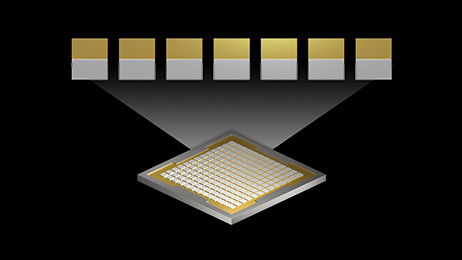

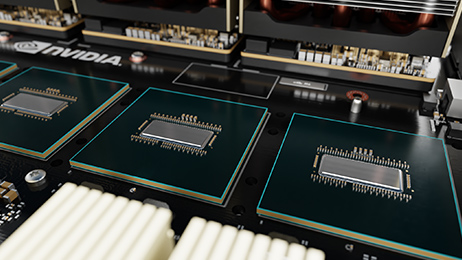

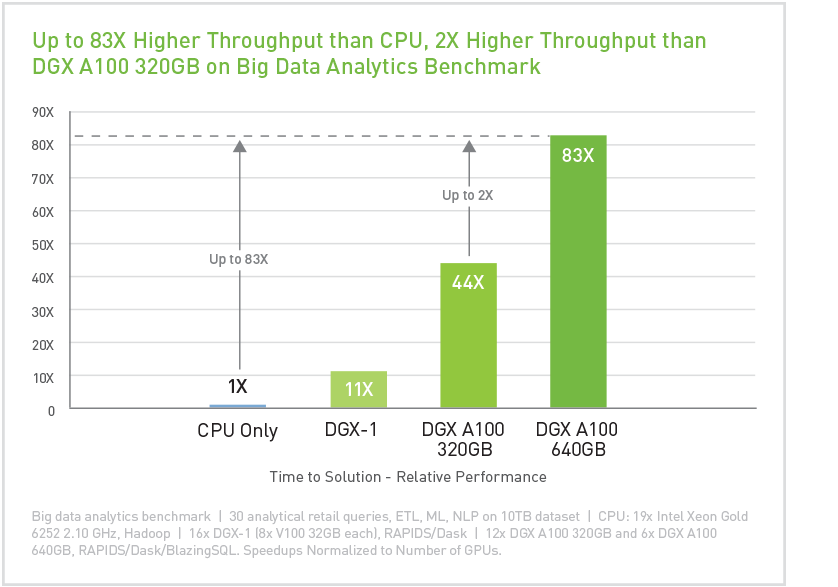

NVIDIA DGX™ A100 ist das universelle System für alle KI-Workloads - von Analysen über Training bis hin zu Inferenzen. Der DGX A100 setzt neue Maßstäbe für die Rechendichte: Er packt 5 petaFLOPS KI-Leistung in einen 6U-Formfaktor und ersetzt die bisherige Recheninfrastruktur durch ein einziges, einheitliches System. Der DGX A100 bietet außerdem die beispiellose Fähigkeit, Rechenleistung feinkörnig zuzuweisen, indem die Multi-Instance-GPU (MIG)-Funktion der NVIDIA A100 Tensor Core GPU genutzt wird, die es Administratoren ermöglicht, Ressourcen zuzuweisen, die für bestimmte Workloads richtig dimensioniert sind.

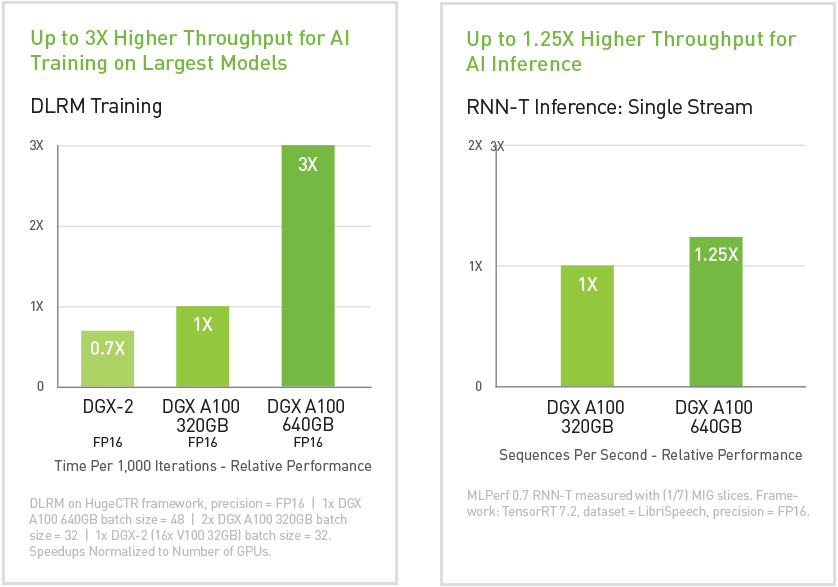

Der DGX A100 ist mit bis zu 640 Gigabyte (GB) GPU-Gesamtspeicher erhältlich, was die Leistung bei umfangreichen Trainingsjobs bis zum Dreifachen steigert und die Größe von MIG-Instanzen verdoppelt. So kann der DGX A100 sowohl die größten und komplexesten als auch die einfachsten und kleinsten Jobs bewältigen. Der DGX A100 läuft mit dem DGX Software-Stack und optimierter Software von NGC. Die Kombination aus dichter Rechenleistung und vollständiger Workload-Flexibilität macht den DGX A100 zu einer idealen Wahl sowohl für Einzelknoten-Implementierungen als auch für groß angelegte Slurm- und Kubernetes-Cluster, die mit NVIDIA DeepOps bereitgestellt werden.

IT DEPLOYMENT SERVICES VERFÜGBAR

Möchten Sie die Zeit bis zu Erkenntnissen verkürzen und den ROI von KI beschleunigen? Lassen Sie unser professionelles IT-Team das weltweit erste 5 petaFLOPS KI-System, NVIDIA® DGX™ A100, nahtlos und ohne Unterbrechung mit 24/7-Support in Ihre Infrastruktur beschleunigen, bereitstellen und integrieren.

Erhalten Sie die Ergebnisse und Resultate, die Sie benötigen:

- Standortanalyse, Bereitschaft, Vortest und Inszenierung

- Zugriff auf engagierte Ingenieure, Lösungsarchitekten und Support-Techniker

- Einsatzplanung, Terminplanung und Projektmanagement

- Versand, Logistikmanagement und Bestandsbereitstellung

- Vor-Ort-Installation, Vor-Ort- oder Fernkonfiguration der Software

- Nach dem Einsatz Check-up, Support, Ticketing und Wartung

- Lebenszyklusmanagement einschließlich Design, Upgrades, Wiederherstellung, Reparatur und Entsorgung

- Rack- und Stack- sowie Integrationsservices und Bereitstellung an mehreren Standorten

- Maßgeschneiderte Break-Fix- und Managed-Service-Verträge